Hoe NLP en AI taal begrijpen en je zoekfunctie, content en klantenservice slimmer maken

Benieuwd hoe AI taal echt begrijpt en wat jij ermee kunt? Deze blog legt helder uit wat NLP is-van embeddings en transformers tot taken als sentiment, entiteiten en samenvatten-en laat zien hoe je chatbots, zoeken en documentverwerking slimmer maakt. Met praktische stappen, evaluatietips en aandacht voor privacy en bias, plus inspirerende cases uit e-commerce, zorg, overheid en finance.

Wat is natural language processing (NLP)

Natural language processing (NLP) is het deel van kunstmatige intelligentie (AI) dat computers leert omgaan met natuurlijke taal: de woorden en zinnen die je dagelijks spreekt of typt. In de kern laat je met NLP een systeem tekst of spraak omzetten in betekenis, zodat het vragen kan beantwoorden, documenten kan samenvatten of een gesprek met je kan voeren. Dat gebeurt in stappen: ruwe taal wordt opgeschoond en in kleine stukjes verdeeld (tokenization), waarna een model verbanden en context leert herkennen. Moderne NLP gebruikt embeddings, wiskundige representaties die woorden als punten in een ruimte plaatsen, zodat je systeem kan voelen dat “fiets” dichter bij “fietshelm” ligt dan bij “meteoriet”. Met transformers en attention-de architectuur achter veel large language models (LLM’s)-krijg je modellen die lange context begrijpen en vloeiend tekst genereren.

NLP raakt zowel tekst (e-mails, reviews, contracten) als spraak, via spraak-naar-tekst en spraaksynthese. In de praktijk helpt ai nlp je bij zoekfuncties die echt snappen wat je bedoelt, chatbots die natuurlijk reageren, vertaling, sentimentanalyse en informatie-extractie uit grote documenten. Belangrijk om te weten: goede resultaten vragen om representatieve data, zorg voor privacy en voortdurende evaluatie, want taal en domeinen veranderen. Samengevat: met natural language processing zet je natuurlijke taal om in actiegerichte inzichten, waardoor je processen slimmer maakt en interacties met technologie natuurlijker aanvoelen.

Natural language processing definition en kernbegrippen

Natural language processing (NLP) is het deel van AI dat computers leert menselijke taal te begrijpen, te analyseren en te genereren. Je laat systemen werken met tekst en spraak door taal om te zetten in getallen die modellen kunnen verwerken. Belangrijke kernbegrippen zijn tokenization (tekst opdelen in woorden of subwoorden), corpus (je verzameling trainingsdata), en preprocessing zoals normalisatie, lemmatisatie en het verwijderen van stopwoorden. Met embeddings zet je woorden en zinnen om in vectoren die betekenis en context vastleggen.

Moderne modellen gebruiken transformers met attention om relaties in lange zinnen te begrijpen. Taken als intent-herkenning en named entity recognition (entiteiten uit tekst halen) combineren syntax (zinsstructuur) en semantiek (betekenis). Je traint doorgaans met gelabelde data (supervised), soms onbewaakt (unsupervised), en beoordeelt met metrics zoals precision, recall en F1.

NLP in AI: hoe natural language processing in AI past binnen kunstmatige intelligentie

NLP is een kernonderdeel van AI dat je systemen laat communiceren in natuurlijke taal en zo de brug vormt tussen ruwe data en bruikbare beslissingen. Binnen de AI-stapel levert NLP de taalintelligentie bovenop machine learning en deep learning: modellen zoals transformers en LLM’s zetten tekst en spraak om in representaties waarmee je intenties, entiteiten, sentiment en relaties herkent. NLP werkt nauw samen met spraaktechnologie (spraak-naar-tekst en spraaksynthese), kennisrepresentatie (knowledge graphs) en information retrieval, bijvoorbeeld via retrieval-augmented generation om antwoorden feitelijker te maken.

In multimodale AI combineer je taal met beeld of tabellen voor rijkere context. Praktisch betekent dit dat je chatbots, zoekfuncties, vertaling en documentverwerking slimmer en menselijker maakt, terwijl governance rond privacy, bias en veiligheid integraal onderdeel blijft van het AI-ontwerp.

Hoe language processing werkt: van tekst tot betekenis

Je start met ruwe tekst en maakt die modelklaar via stappen als normaliseren, zins- en woordsegmentatie en eventueel lemmatisatie, zodat “lopen” en “liep” als dezelfde basisvorm tellen. Daarna zet je woorden om naar embeddings: getalrepresentaties die betekenis en context vastleggen. Een transformer-model met attention weegt elk woord ten opzichte van de rest van de zin en bouwt zo een contextueel begrip op.

Afhankelijk van je taak vertaalt het model deze representaties naar uitkomsten zoals intentie, sentiment, entiteiten of een samenvatting. Bij genereren gebruikt het een decoder om vloeiende zinnen te produceren. Post-processing zet labels of tekst om in acties in je applicatie. Ambiguïteit los je op met meer context, domeinspecifieke fine-tuning of retrieval uit je eigen kennisbronnen.

[TIP] Tip: Begin met voorgetrainde modellen; valideer met kleine, representatieve datasets.

Technieken en modellen in NLP

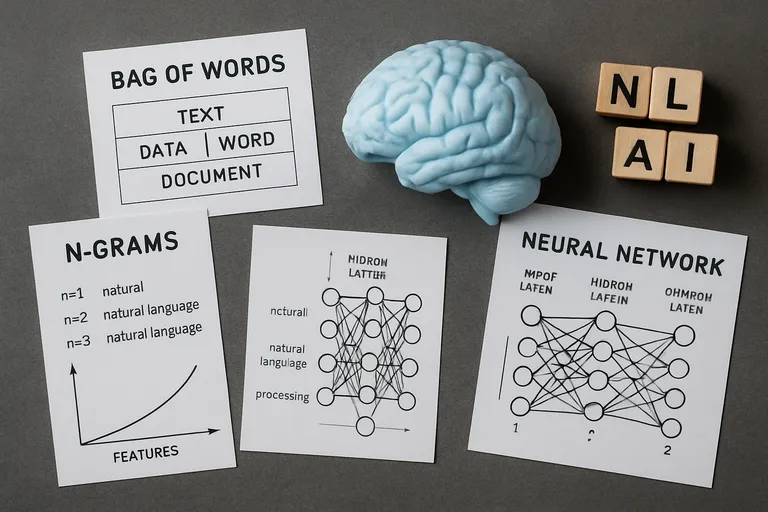

NLP is geëvolueerd van regels en woordenlijsten naar data-gedreven modellen die patronen zelf leren. Vroeger werkte je met bag-of-words, n-grams en handgemaakte features; daarna kwamen statistische modellen zoals SVM’s en CRF’s voor classificatie en sequence tagging. Neural nets brachten eerst RNN’s en LSTM’s voor context over zinnen heen, maar transformers namen het over dankzij attention, waarmee je lange afhankelijkheden soepel modelleert. Woorden worden weergegeven als embeddings: eerst statisch (word2vec, GloVe), nu contextueel via modellen als BERT. Architecturen variëren van encoder-only (begrijpen en classificeren) tot encoder-decoder (vertalen, samenvatten) en decoder-only LLM’s (genereren en redeneren).

Je traint meestal met self-supervised pretraining (bijv. masked language modeling of next-token) en past daarna aan met fine-tuning, parameter-efficiënte technieken zoals adapters of prompt-tuning. Voor domeinspecifieke taken combineer je modellen met retrieval-augmented generation om actuele of bedrijfsinterne kennis op te halen. In productie let je op latency, kosten, privacy en bias, en kies je tussen een compact model on-prem of een grotere cloud-LLM, afhankelijk van je eisen rond schaal, veiligheid en controle.

Van regels naar machine learning en deep learning

Onderstaande vergelijking zet regelgebaseerde NLP naast klassieke machine learning en deep learning, zodat je snel ziet wanneer welke benadering het meest geschikt is en waarom.

| Benadering | Kernidee | Data & features | Voorbeelden & wanneer inzetten |

|---|---|---|---|

| Regelgebaseerde NLP | Handmatige regels, woordenlijsten en patroonherkenning (bijv. regex, grammaticaregels); deterministisch en goed controleerbaar. | Weinig tot geen gelabelde data; leunt op taalkennis en domeinspecifieke woordenlijsten; onderhoud door experts. | Tokenisatie, normalisatie, datum/adres-extractie, eenvoudige entiteitdetectie. Ideaal bij stabiele formats, hoge precisie-eisen en compliance. |

| Klassieke machine learning | Statistische modellen leren van gelabelde voorbeelden; prestaties hangen af van feature engineering. | Gelabelde datasets; handgemaakte features zoals bag-of-words, n-grams, TF-IDF, POS-tags; modellen o.a. Naive Bayes, Logistic Regression, SVM, CRF. | Document-/spamclassificatie, intentieherkenning, NER met CRF. Geschikt bij middelgrote datasets, behoefte aan uitlegbaarheid en snelle training. |

| Deep learning | Neurale netwerken leren representaties end-to-end; context via RNN/CNN/vooral Transformers; vaak pretraining + fine-tuning. | Veel data en rekenkracht, of gebruik van voorgetrainde embeddings/LLM’s; minder handmatige features nodig. | Sentiment, samenvatten, vraag-antwoord, NER zonder feature engineering, zero/few-shot met LLM’s. Sterk bij variabele taal en domeinoverstijgende taken; let op kosten, privacy en bias. |

Kerninzicht: start met regels voor smalle, stabiele use-cases, schaal op naar klassieke ML bij meer data en behoefte aan generalisatie, en kies deep learning of LLM’s voor complexe, contextrijke taken en beste prestaties.

Ooit bouwde je NLP-systemen vooral met regels: woordenlijsten, grammatica’s en regex die je zelf onderhoudt. Dat werkt helder en voorspelbaar, maar breekt snel bij variatie, sarcasme of nieuwe termen en schaalt slecht naar meerdere talen en domeinen. Met machine learning stap je over op statistische modellen zoals Naive Bayes, SVM en CRF die patronen leren uit gelabelde data, gevoed door features die je handmatig ontwerpt. Deep learning haalt die feature-engineering grotendeels weg: RNN’s en LSTM’s vangen volgorde en context, CNN’s herkennen lokale patronen, en transformers met attention begrijpen lange afhankelijkheden en leveren state-of-the-art prestaties.

Je ruilt regels in voor data en rekenkracht, vaak aangevuld met pretraining en fine-tuning. In de praktijk combineer je nog steeds eenvoudige regels met modellen voor robuustheid, traceerbaarheid en kostenbeheersing.

Moderne modellen: transformers, embeddings, attention en LLM’s

Transformers vormen de ruggengraat van moderne NLP omdat ze met self-attention relaties tussen woorden over lange afstanden kunnen wegen zonder volgorde stap voor stap te doorlopen. Je start met embeddings: compacte vectoren die tokens als betekenisvolle punten in een ruimte plaatsen. Door meerdere transformerlagen worden die embeddings contextueel, zodat hetzelfde woord in een andere zin een andere betekenis krijgt. Multi-head attention laat een model tegelijk naar verschillende patronen kijken.

LLM’s zijn grote, meestal decoder-only transformers die getraind zijn op next-token voorspellen en daarna via instructietuning of RLHF leren reageren op je prompts. Encoder-only varianten (zoals BERT-achtige modellen) scoren sterk op begrijpen, terwijl encoder-decoder modellen (zoals T5-achtige) uitblinken in vertalen en samenvatten. Je past ze aan met fine-tuning, parameter-efficiënt (LoRA) of puur met prompting, en combineert ze vaak met retrieval om actuelere, feitelijke antwoorden te geven.

Belangrijkste taken in AI NLP: classificatie, entity recognition, sentiment, samenvatten en vraag-antwoord

In ai nlp draait veel om een paar kernactiviteiten die je in vrijwel elke toepassing terugziet. Met tekstclassificatie geef je documenten labels, zoals “klacht”, “verkoopkans” of een onderwerp, zodat je automatisch kunt routeren of prioriteren. Named entity recognition haalt namen van personen, organisaties, locaties, bedragen en datums uit tekst, handig voor contractanalyse en KYC-processen. Sentimentanalyse meet de toon van een bericht, van negatief tot positief, zodat je sneller kunt reageren op ontevreden klanten.

Samenvatten condenseert lange teksten naar de kern zonder cruciale informatie te verliezen. Vraag-antwoord kan extractief zijn (een passage aanwijzen) of generatief (een compleet antwoord formuleren), vaak versterkt met retrieval voor actuele feiten. Samen vormen deze taken de bouwblokken van moderne natural language processing.

[TIP] Tip: Begin met regelgebaseerde baselines; meet winst van elk model.

Toepassingen van NLP AI in de praktijk

NLP AI maakt taalgestuurde processen slimmer en sneller, van klantcontact tot risicobeheer. Je bouwt chatbots en virtuele assistenten die vragen direct afhandelen, met natural language processing die intenties en context snapt en antwoorden personaliseert. In zoek en aanbevelingen helpt ai nlp je om te zoeken op betekenis in plaats van exacte woorden, wat vooral in e-commerce en intranet-omgevingen tot betere resultaten leidt. In documentverwerking zet je language processing in voor automatische classificatie, entiteitsextractie en samenvatten, ideaal voor contractanalyse, claims, e-discovery en KYC/AML-controles.

Vertaling en spraak-naar-tekst maken meertalige workflows mogelijk, bijvoorbeeld in zorg en overheid waar snelle, toegankelijke communicatie telt. In finance detecteer je met sentiment en topic mining signalen in nieuws en klantberichten, terwijl je in HR cv’s en vacatures semantisch matcht. Met retrieval-augmented generation geef je medewerkers feitelijke, contextspecifieke antwoorden uit je eigen kennisbronnen. Door NLP in je CRM, ERP of DMS te integreren, automatiseer je routinewerk, verklein je doorlooptijden en verhoog je servicekwaliteit, terwijl je met goede governance privacy en veiligheid borgt.

Conversatie, zoeken en aanbevelingen

Met NLP bouw je gesprekken die natuurlijk aanvoelen: intentieherkenning bepaalt wat je bedoelt, dialoogmanagement houdt de draad vast over meerdere turns, en een geheugenlaag bewaart context zoals voorkeuren of eerdere antwoorden. In zoeken stap je over van exacte trefwoorden naar semantische zoektechniek, waarbij embeddings (vectorrepresentaties van tekst) en vector search resultaten op betekenis rangschikken. Zo vind je sneller het juiste antwoord in helpdesks, intranetten of productcatalogi.

Aanbevelingen profiteren van taal door productbeschrijvingen, reviews en profielgegevens te begrijpen en te koppelen, zodat je gepersonaliseerde suggesties geeft, zelfs bij cold starts met weinig klikdata. Met retrieval-augmented generation combineer je conversatie met je eigen kennisbronnen voor feitelijke, contextspecifieke reacties. Vergeet niet feedback te loggen en privacy te borgen, anders verarmt de kwaliteit en loop je risico’s.

Documentverwerking, vertaling en spraak-naar-tekst

Met NLP automatiseer je documentverwerking: je haalt tekst uit pdf’s en scans via OCR (optische tekenherkenning), classificeert documenten, extraheert velden zoals namen, bedragen en datums en maakt een samenvatting voor snelle beoordeling. Voor vertaling gebruik je neurale machinevertaling die zinscontext meeneemt; met glossaries en domein-specifieke fine-tuning houd je vaktermen consistent. Spraak-naar-tekst zet audio om in nauwkeurige transcripties, inclusief interpunctie, sprekerdiarisatie (wie spreekt wanneer) en ondersteuning van Nederlandse en Vlaamse accenten.

Je koppelt deze stappen aan kwaliteitscontrole en menselijke review bij kritieke processen. Denk aan privacy: verwerk gevoelige data on-prem of pseudonimiseer waar mogelijk, en log fouten om de modellen gericht te verbeteren.

Sectorcases in Nederland en België: e-commerce, zorg, overheid en finance

In e-commerce gebruik je NLP voor semantisch zoeken, aanbevelingen en automatische producttagging, plus sentiment op reviews om assortiment en service te sturen. In de zorg help je met triage-assistenten, transcripties en samenvattingen van consulten, en het structureren van EPD-notities, met privacy-by-design volgens de AVG en lokale richtlijnen. Overheden versnellen dienstverlening met chatbots voor vergunningen, Wmo- en belastingvragen, en verwerken Woo-verzoeken door documenten te classificeren, te anonimiseren en samen te vatten, inclusief meertaligheid voor Nederlands en Frans.

In finance zet je NLP in voor KYC/AML, screening van klantcommunicatie, claimsafhandeling en het opsporen van risico’s in contracten en nieuws. Zo verklein je doorlooptijden, versterk je compliance en voelt klantcontact menselijker.

[TIP] Tip: Label eerst 100 voorbeelden; valideer met gebruikers voordat je opschaalt.

Aan de slag met NLP: stappen, evaluatie en valkuilen

Je start met een concreet doel: welk probleem los je op en welke output heb je nodig (label, antwoord, samenvatting of actie). Daarna inventariseer je data: bronnen, kwaliteit, representativiteit en privacy-eisen volgens AVG. Je maakt een klein, goed gedefinieerd datasetje met duidelijke annotatierichtlijnen en bouwt een baseline, bijvoorbeeld een simpel classificatiemodel of een prompt voor een LLM, zodat je weet waar je vandaan komt. Vervolgens kies je een aanpak: fine-tunen van een bestaand model, parameter-efficiënt (LoRA) of werken met retrieval-augmented generation om eigen kennis veilig te gebruiken. Evalueren doe je met heldere metrics per taak: precision, recall en F1 voor classificatie of entity recognition, ROUGE/BLEU voor samenvatten en vertaling, en naast cijfers altijd menselijke review op feitelijkheid, toon en inclusiviteit.

Test eerlijk met gescheiden train/valid/test-splits en voorkom dat je lekt tussen datasets of prompt en evaluatie. In productie bewaak je latency, kosten en veiligheid, monitor je datadrift en errors, en voer je A/B-tests en feedbackloops uit. Veelgemaakte fouten zijn te weinig domeindata, onduidelijke labels, bias in voorbeelden, vergeten governance en onvoldoende beveiliging tegen prompt injection. Door klein te beginnen, iteratief te verbeteren en continu te meten, breng je NLP betrouwbaar van idee naar impact.

Stappenplan van probleem naar prototype

Begin met een scherpe probleemdefinitie: wat wil je automatiseren en welke uitkomst telt? Leg meteen je succesmetric vast, zoals F1-score voor classificatie of nauwkeurigheid van antwoorden. Verzamel voorbeelddata die je situatie echt weerspiegelt, schrijf korte annotatierichtlijnen en label een klein, representatief setje. Bouw een baseline: start simpel met een regelset of een few-shot prompt bij een LLM om te zien wat “goed genoeg” betekent.

Kies daarna een aanpak: alleen prompten, light fine-tuning of combineren met retrieval uit je eigen kennisbronnen. Splits train/val/test eerlijk, evalueer, en herhaal gericht op de grootste fouten. Check privacy en AVG-eisen, verwijder persoonsgegevens waar kan. Lever een klikbaar prototype op, log feedback van gebruikers, en verbeter iteratief tot je klaar bent voor een kleine pilot.

Evaluatie en monitoring: precision, recall, F1, BLEU en mensgerichte feedback

Je beoordeelt NLP-systemen met heldere metrics en echte gebruikerssignalen. Precision meet hoe vaak je positieve voorspellingen kloppen, recall hoeveel echte positieven je vindt, en F1 balanceert beide via het harmonisch gemiddelde. Voor vertaling en soms samenvatten gebruik je BLEU om overeenkomsten met referentieteksten te scoren, al blijft dit beperkt bij creatievere output. Daarom koppel je altijd mensgerichte feedback terug: laat reviewers scoren op juistheid, volledigheid, toon en veiligheid, liefst met duidelijke rubrics en side-by-side vergelijkingen.

In productie monitor je continu prestaties per segment, datadrift, latency en foutpatronen, werk je met een vaste “golden set” voor regressietests en run je A/B-tests op nieuwe versies. Log expliciete feedback en corrigeer snel met herlabelen, promptupdates of fine-tuning.

Veelgemaakte fouten: datakwaliteit, privacy, bias en schaalbaarheid

De meeste NLP-problemen beginnen bij data: je traint op rommelige, onvolledige of scheef verdeelde voorbeelden, waardoor je model hallucinaties of foute labels kopieert. Zonder duidelijke annotatierichtlijnen en een strakke kwaliteitscontrole sluipt inconsistentie erin en krijg je onstabiele prestaties. Privacy gaat mis wanneer je persoonsgegevens (PII) onnodig opslaat of deelt; je checkt dus AVG-grondslag, minimaliseert data, pseudonimiseert en stelt bewaartermijnen in.

Bias ontstaat als je voorbeelden één groep over- of ondervertegenwoordigen; meet prestaties per segment, pas sampling aan en voer fairness-checks uit. Schaalbaarheid knelt wanneer je geen rekening houdt met latency, kosten en piekbelasting; optimaliseer met batching, caching, quantization en passende hardware. Vergeet tenslotte geen rollback-plan en monitoring, anders kun je degradatie niet tijdig zien of herstellen.

Veelgestelde vragen over natural language processing

Wat is het belangrijkste om te weten over natural language processing?

Natural language processing (NLP) is het vakgebied dat computers leert menselijke taal te begrijpen, genereren en gebruiken. Het combineert linguïstiek en AI, gebruikt modellen zoals transformers, en ondersteunt taken als classificatie, entiteitsherkenning, samenvatten en vraag-antwoord.

Hoe begin je het beste met natural language processing?

Start met een concreet gebruiksdoel en representatieve data. Maak een simpele baseline (regex of klassieke ML), definieer meetwaarden zoals precision, recall en F1, en verbeter iteratief met embeddings of een geschikte transformer. Waarborg privacy.

Wat zijn veelgemaakte fouten bij natural language processing?

Veelgemaakte fouten: slechte datakwaliteit en labelbias, datasnooping/leakage tussen train en test, te weinig domeinrepresentativiteit, geen monitoring of mensgerichte feedback, overschatten van LLM’s zonder veiligheidsmaatregelen, en schaalproblemen rond latency, kosten en geheugen.